一文读懂数据中心计算市场CPU、DPU和GPU的区别

随着AI、5G和云计算技术逐渐火爆全球,数据中心作为承载和支撑数字化转型的重要载体,正面临着前所未有的挑战。今天我们先来了解作为数据中心未来计算的三大支柱(CPU、DPU和GPU)的演进历程和三者之间的协作关系。

- CPU

CPU的全称是 Central Processing Unit(中央处理器),在三大支柱中是发展最早的,主要包括运算器(ALU, Arithmetic and Logic Unit)和控制单元(CU, Control Unit),寄存器(Register)、高速缓存器(Cache)和它们之间通讯的数据、控制及状态的总线。CPU遵循的是冯诺依曼架构,即存储程序、顺序执行。

一条指令在CPU中执行的过程是:读取到指令后,通过指令总线送到控制器中进行译码,并发出相应的操作控制信号。然后运算器按照操作指令对数据进行计算,并通过数据总线将得到的数据存入数据缓存器。

因此,CPU需要大量的空间去放置存储单元和控制逻辑,相比之下计算能力只占据了很小的一部分,所以CPU更擅长逻辑控制,而非大规模并行计算能力。

2.GPU

GPU(Graphics Processing Unit,图形处理器)的诞生是为了解决CPU在大规模并行运算中受到的速度限制。正如图像处理器名称一样,GPU更善于处理图像领域的运算加速,最初是用在个人电脑、工作站、游戏机和一些移动设备上运行绘图运算工作的微处理器。

那么为什么GPU特别擅长处理图像数据呢?

这是因为在图像上的每一个像素点都有被处理的需要,而且每个像素点处理的过程和方式都十分相似,因此可以并行计算,所以GPU在图像处理方面的能力就非常强。但是GPU无法单独工作,必须由CPU进行控制调用才能工作。也就是说CPU可单独作用,处理复杂的逻辑运算和不同的数据类型,但当需要大量的处理类型统一的数据时,则可调用GPU进行并行计算。

3.DPU

DPU,全名Data Processing Units(数据处理单元),DPU主要承担起安全、网络、存储和AI等业务的加速处理,旨在降低CPU的利用率,满足网络专用计算需求,尤其适用于服务器量多、对数据传输速率要求严苛的场景。

回顾数据中心架构发展历程,传统的数据中心架构是以CPU为中心的架构,这代表着数据中心基础架构的运行能够消耗20%-30%的CPU核,这在数据中心庞大的数据处理任务中是一个非常严重的绊脚石存在。而DPU为中心的数据中心架构是指以数据为中心的市场发展和应用需求,也可以说新的数据中心架构是指数据在哪计算就在哪。与传统的数据中心架构相比,以数据为中心的新架构在解决网络传输中的瓶颈问题或者丢包问题时,典型通信延时可以从30-40微秒降低到3-4微秒,有10倍的性能提升。

特别是去年4月,英伟达宣布完成对以色列网络芯片商Mellanox高达69亿美元的收购交易,将DPU芯片推至半导体领域的焦点。而今年的四月,英伟达首席执行官黄仁勋在 GTC 21 上又宣布英伟达数据中心芯片战略升级为 GPU+CPU+DPU。与此同时,英特尔、中科奴数、Marvell等国内外芯片厂家也都陆续推出自己的DPU产品。

一时间,DPU产品的研发成为全球半导体领域炙手可热的焦点。

现如今数据中心倡导以资源池的形式来做,各类资源分别管理、扩容,而DPU宛如一个连接枢纽,可以起到中心调度管理的作用,一端连接各种CPU、GPU、SSD、FPGA加速卡等本地资源,一端连接交换机/路由器等网络资源。当然,DPU 的出现并非要替代 CPU 和 GPU,而是更好地满足数据中心市场的需求。三者协作,才是未来数据中心计算领域的前沿发展趋势

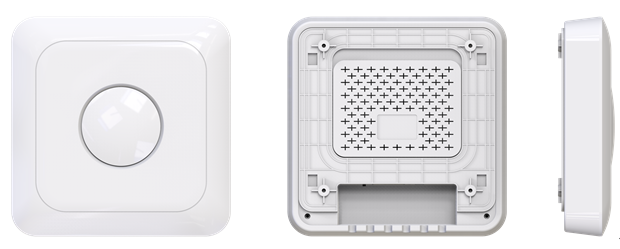

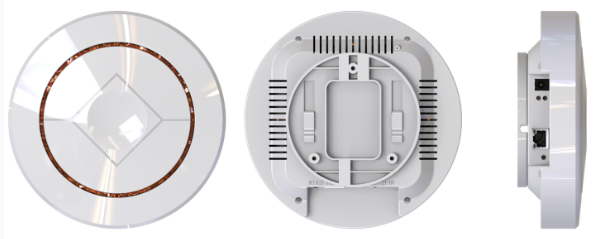

LR-LINK联瑞作为全球网卡领域产销规模领先的高新技术企业,在网卡应用领域市场上占据着非常重要的影响地位。15年来,LR-LINK联瑞坚持以市场需求为根本,以未来产业发展为导向,不断引领网卡行业的发展趋势,其先后研发出的千兆M12接口轨道交通网卡、25G(芯片:intel XXVAM2)双光口服务器网卡、国产万兆OCP 3.0专用网卡(宽温设计)、千兆十二电口网卡等十余款新品不断刷新业界同类型产品记录。未来,LR-LINK联瑞也将在基于GPU、DPU等芯片基础上,研发出更适应未来数据中心计算应用领域的服务器网卡。

蓄势待发,砥砺前行,LR-LINK联瑞,未来可期!

登录

登录

注册

注册